RL Swarm: Hệ thống khung cho học tăng cường hợp tác

Đây là mã nguồn mở (Giấy phép MIT) dành cho các nút ngang hàng thực hiện học tăng cường hợp tác qua internet, có thể truy cập được bởi bất kỳ ai sử dụng phần cứng máy tính cá nhân hoặc trung tâm dữ liệu.

Chúng tôi đã từ lâu tin tưởng, rằng tương lai của học máy sẽ phân tán và phân mảnh. Các mô hình monolit hiện tại của chúng ta sẽ được thay thế bằng các tham số phân mảnh, tồn tại trên từng thiết bị trên toàn cầu. Trong nghiên cứu của chúng tôi, chúng tôi đã khám phá các con đường khác nhau dẫn đến tương lai này và gần đây phát hiện rằng học tăng cường (RL) hoạt động đặc biệt hiệu quả khi các mô hình được huấn luyện hợp tác, giao tiếp với nhau và chỉ trích các phản hồi của nhau.

Chúng tôi đã kết luận rằng các mô hình RL học nhanh hơn khi chúng được huấn luyện như một cộng đồng tập thể, thay vì một mình. Chi tiết về cơ chế này có thể được đọc ở đây hoặc tham gia trình diễn trực tiếp để xem công nghệ này trong hành động.

Cách hoạt động

Trong thiết lập của chúng tôi, mỗi nút trong cộng đồng sẽ chạy mô hình Qwen 2.5 1.5B và giải quyết các bài toán toán học (GSM8K) theo ba giai đoạn:

- Giai đoạn 1 (Phản hồi):

Mỗi mô hình giải quyết bài toán một cách độc lập, đưa ra lý luận và phản hồi của mình theo định dạng đã chỉ định. - Giai đoạn 2 (Phê bình):

Mỗi mô hình xem xét các câu trả lời được cung cấp bởi các mô hình khác và đưa ra phản hồi của mình. - Giai đoạn 3 (Giải quyết):

Mỗi mô hình bỏ phiếu cho câu trả lời tốt nhất cho mỗi câu hỏi. Sau đó, mỗi mô hình đưa ra câu trả lời cuối cùng đã được sửa đổi.

Trong các thí nghiệm của chúng tôi, chúng tôi nhận thấy rằng hệ thống này tăng tốc học tập, cho phép các mô hình đưa ra câu trả lời chính xác hơn trên các dữ liệu kiểm tra chưa thấy với số lượng bước huấn luyện ít hơn.

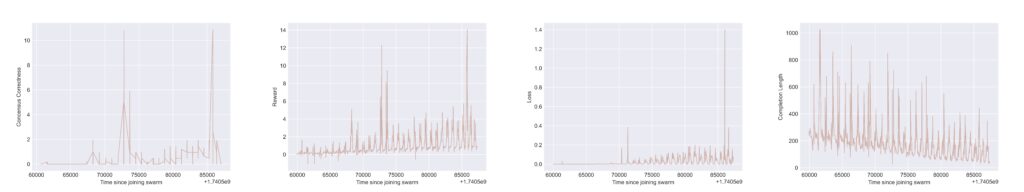

Các biểu đồ trên hiển thị kết quả Tensorboard từ một nút trong đàn. Trong mỗi biểu đồ, chúng ta thấy hành vi tuần hoàn như một sản phẩm phụ của việc “thiết lập lại” giữa các vòng của trò chơi nhiều giai đoạn. Tất cả các biểu đồ đều có trục x là thời gian kể từ khi tham gia đàn. Đối với trục y, từ biểu đồ ngoài cùng bên trái sang phải, chúng ta thấy:

i) “Phần thưởng đúng đắn đồng thuận” (consensus correctness reward), thể hiện khi người tham gia trong đàn này định dạng chính xác các lựa chọn cho câu trả lời tốt nhất và câu trả lời được chọn thực sự chính xác về mặt toán học;

ii) Tổng phần thưởng (total reward), là tổng trọng số của một số phần thưởng dựa trên quy tắc (ví dụ: kiểm tra định dạng và tính đúng đắn về mặt toán học/logic của các phản hồi);

iii) Mất mát huấn luyện (training loss), thể hiện tín hiệu phản hồi để tối đa hóa phần thưởng được truyền đi để cập nhật LLM “cơ sở”; và

iv) Độ dài hoàn thành phản hồi (response completion length) của mô hình, thể hiện số lượng token trong phản hồi đầu ra (điều này cho thấy các mô hình học cách trở nên ngắn gọn hơn khi được đánh giá bởi các đồng nghiệp).

Tham gia cộng đồng

Để trình diễn hệ thống này và mở rộng các thí nghiệm, chúng tôi phát hành trình diễn trực tiếp, nơi bất kỳ người dùng nào cũng có thể tham gia. Đây là một hệ thống hoàn toàn mở để xây dựng các cộng đồng học RL qua Internet.

Việc khởi chạy swarm-node cho phép bạn tạo một cụm mới hoặc kết nối với một nút đã tồn tại, sử dụng địa chỉ công khai của nó. Mỗi cụm thực hiện học tăng cường hợp tác (RL), áp dụng hệ thống trao đổi tin đồn trên nền tảng Hivemind để cải thiện mô hình chung.

Việc khởi chạy khách hàng tích hợp cho phép kết nối với cụm, nhận thông điệp và huấn luyện mô hình của bạn một cách cục bộ như một phần của cộng đồng. Trong tương lai, chúng tôi sẽ phát hành nhiều thí nghiệm hơn cho hệ thống roá và rất mong sự tham gia rộng rãi của cộng đồng.

Tham gia vào “roá”

Báo cáo kỹ thuật

***

RL Swarm là cái nhìn về tương lai của học máy. Nó cung cấp một hệ thống khung cho RL hợp tác giữa các thành viên, nơi trí tuệ sử dụng sự thông thái tập thể thay vì một nhóm các phòng thí nghiệm khép kín. Mở rộng sẽ đụng phải một mạng tính toán mở, kết nối mỗi thiết bị trên thế giới. Chi tiết — sắp có.