Diverse Expert Ensembles: Các LLM song song dựa trên các chuyên gia khác nhau

Đây là bài báo khoa học bàn về lợi ích của sự đa dạng (kích thước mô hình khác nhau và số bước huấn luyện khác nhau) khi huấn luyện các bộ hợp chuyên gia với xử lý song song. Chúng tôi phát hiện ra rằng các mô hình đa dạng, được huấn luyện trên các nguồn tài nguyên tính toán khác nhau trong khoảng thời gian khác nhau, cho kết quả tốt hơn khi kết hợp so với các mô hình đồng nhất được huấn luyện với các cấu hình giống nhau.

Diverse Expert Ensembles

Các mô hình Mixture-of-Experts (MoE) tiếp tục trở nên phổ biến nhờ hiệu quả tính toán và hiệu suất của chúng. Tuy nhiên, mặc dù có cấu trúc mô-đun, chúng ta vẫn huấn luyện chúng giống như các mạng lưới monolit dày đặc. Điều này có nghĩa là, trong các trung tâm dữ liệu lớn, quản lý bởi một tổ chức, sử dụng các tài nguyên tính toán và siêu tham số đồng nhất cho các chuyên gia.

Tại Gensyn, chúng tôi đã từ lâu tin rằng AGI sẽ là một hệ sinh thái mở của các mô hình liên kết — giống như chính Internet — thay vì một mô hình đơn lẻ từ một công ty. Hơn nữa, sự đa dạng của các mô hình sẽ làm mạnh mẽ thêm hệ sinh thái này, thay vì làm yếu đi nó.

Hôm nay, chúng tôi vui mừng giới thiệu kết quả đầu tiên của chúng tôi hỗ trợ cho giả thuyết này.

Introducing Heterogeneous Domain Expert Ensemble (HDEE)

HDEE là một framework để tạo ra các tập hợp chuyên gia đa dạng, tức là các mô hình MoE dị biệt, được huấn luyện với phương pháp học song song.

HDEE dựa trên phương pháp học song song Branch Train Merge (BTM) từ công trình của Li et al., 2022, trong đó chỉ ra rằng “có thể huấn luyện độc lập các mô hình con của lớp LLM mới trên các tập con dữ liệu khác nhau, loại bỏ việc đồng bộ hóa đa nhiệm quy mô lớn mà hiện tại yêu cầu cho việc huấn luyện LLM”. Công trình của chúng tôi cho thấy rằng mở rộng BTM để sử dụng các kích thước mô hình và tham số huấn luyện dị biệt (tức là hỗ trợ các khả năng tính toán khác nhau) thực sự tăng cường hiệu suất của mô hình kết hợp sau này.

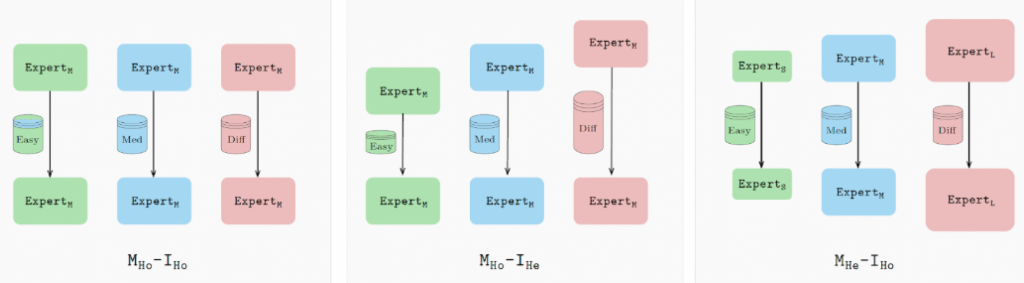

Cụ thể, thay vì huấn luyện tất cả các chuyên gia với các cấu hình giống nhau, HDEE chọn mỗi chuyên gia dựa trên miền dữ liệu và/hoặc khả năng tính toán của nó. Đối với các miền đơn giản, sử dụng mô hình nhỏ hơn (hoặc mô hình được huấn luyện với ít bước hơn); đối với các miền phức tạp hơn, áp dụng các mô hình lớn hơn và huấn luyện lâu hơn.

Những cấu hình này đảm bảo rằng mỗi chuyên gia sẽ được tối ưu hóa tốt nhất, dẫn đến một bộ chuyên gia mạnh mẽ hơn. Nhìn chung, bộ chuyên gia dị biệt đạt được perplexity tốt nhất trong 20 trên 21 miền đánh giá so với mô hình cơ sở, sử dụng ngân sách tính toán tương đương.

Nhìn về tương lai

HDEE cung cấp một cái nhìn ban đầu về hệ sinh thái mô hình mở. Các nhà phát triển độc lập có thể huấn luyện các mô hình trên phần cứng đa dạng, sử dụng các cấu hình phù hợp với dữ liệu và lĩnh vực chuyên môn của họ. HDEE và các phương pháp tương tự có thể kết hợp chúng thành các mô hình meta, định hướng các truy vấn theo con đường tốt nhất, tương tự như chính Internet.

Gensyn đang phát triển cơ sở hạ tầng chính cho điều này, cho phép các nhà phát triển huấn luyện, kiểm tra và kết hợp các mô hình của họ trên tất cả các thiết bị có khả năng ML trên thế giới.

Để tìm hiểu thêm, bạn có thể đọc bài báo đầy đủ ở đây.

HDEE hoàn toàn mở và chúng tôi khuyến khích cộng đồng nghiên cứu xây dựng phát triển của mình dựa trên mã nguồn này.