CheckFree: تدريب مقاوم للأعطال بدون نقاط تحقق (checkpoints)

هذه ورقة بحثية تصف “CheckFree”، وهي طريقة استعادة جديدة للأعطال في التدريب الموزع التي لا تتطلب نقاط تفتيش أو حسابات زائدة عن الحاجة، مما يتيح تدريبًا فعالًا في وجود أعطال متكررة.

النقاط الأساسية

- تسريع حتى 1.6× مقارنةً بالـ checkpoints التقليدية: كل من CheckFree وCheckFree+ يمكنهما تحقيق تسريع في زمن التدريب يصل إلى 1.6× مقارنةً بالتحقق التقليدي في حالة الأعطال المتكررة أثناء التدريب.

- منهجية جديدة للتعافي بدون checkpoints: يستخدم CheckFree أوزان المراحل المجاورة لتقريب أوزان المرحلة المفقودة.

الخلفية

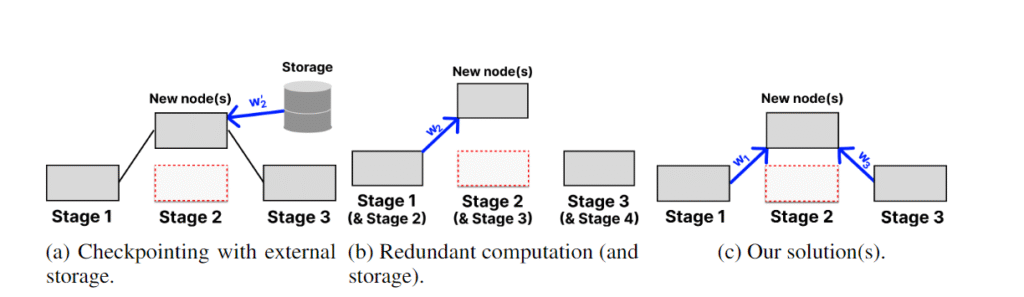

في استراتيجيات الاستعادة المتطورة، يتم حفظ أوزان النماذج (تخزينها بشكل دوري) في وحدة تخزين مركزية سليمة. يمكن أن يكون هذا مكلفًا للغاية، حيث تستغرق نقطة تفتيش واحدة لنموذج LLaMA 70B أكثر من 20 دقيقة في اتصالات النطاق العريض العالية (بافتراض سرعة تزيد عن 500 ميجابت/ثانية). عند حدوث عطل، يتم التراجع عن النموذج بالكامل إلى نقطة التفتيش السابقة، مما يؤدي إلى فقدان ساعات محتملة من التدريب. تم اقتراح Bamboo كبديل لنقاط التفتيش عن طريق الحساب الزائد عن الحاجة – يتم تخزين أوزان مرحلة على المرحلة السابقة وتنفيذ كل دفعة صغيرة تمريرة أمامية بشكل زائد عن الحاجة على النسخ. بهذه الطريقة، عند حدوث عطل واحد، يمكن استئناف التدريب على الفور. ومع ذلك، يثبت مثل هذا التدريب عدم فعاليته للنماذج الكبيرة حيث تحتاج كل عقدة إلى مضاعفة متطلبات الذاكرة لتخزين الطبقات الزائدة عن الحاجة. توفر CheckFree وCheckFree+ بديلاً عملياً في التدريب الجغرافي الموزع على نطاق واسع، حيث لا تتطلب أي حساب أو اتصال إضافي.

كيف يعمل

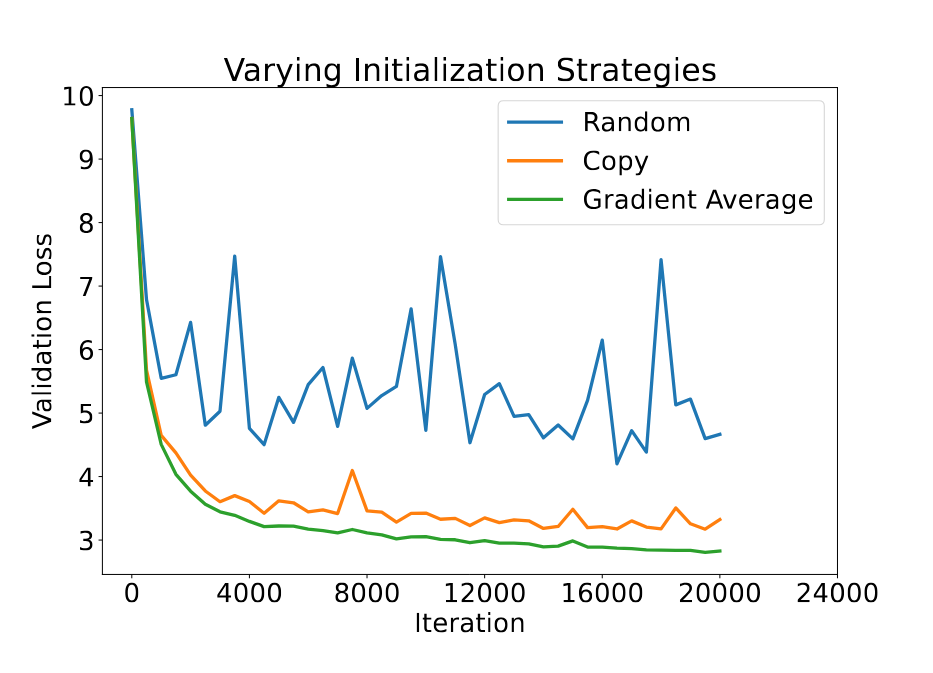

عند حدوث عطل، يتم استعادة المرحلة المفقودة عبر المتوسط الوزني لمرحلتين مجاورتين. هذا يعتمد على التكرار الطبيعي للطبقات في LLM، كما أظهرت أعمال سابقة أن حذف بعض الطبقات لا يؤثر كثيرًا على أداء النموذج. نظهر تجريبيًا أن المتوسط يتفوق على النسخ المباشر المستخدم عادةً في أبحاث تكديس الطبقات.

الطريقة الأبسط هي المتوسط المتساوي للمرحلتين. لكن هذا لا يميز بين أهمية وتقدم المراحل، ما يؤدي لتباطؤ في تقارب النموذج. لذلك يستخدم CheckFree أوزان آخر gradient norm لتلك المرحلة. مفهوميًا، يعطي هذا وزنًا أكبر للمراحل غير المتقاربة بعد، موزعًا بعض وظيفتها على المرحلة الجديدة. للسماح للمرحلة المعاد تهيئتها بـ “اللحاق”، يزيد CheckFree قليلًا من learning rate لبضع خطوات بعد الاستعادة.

لكن هذه الاستراتيجية لا يمكنها استعادة أوزان المرحلة الأولى أو الأخيرة لغياب جيران. لهذا نقترح CheckFree+. يسمح هذا باستعادة المراحل الطرفية باستخدام out-of-order execution: كل حزمة ثانية تُعيد ترتيب أول مرحلتين وآخر مرحلتين، ما يتيح للطبقات الوسيطة تعلم سلوك جيرانها، مشابهًا للحسابات الزائدة لكن دون تكاليف إضافية في الذاكرة أو الحساب. عند حدوث عطل، يمكن نسخ هذه المراحل “الزائدة” لتعويض المفقود.

النتائج

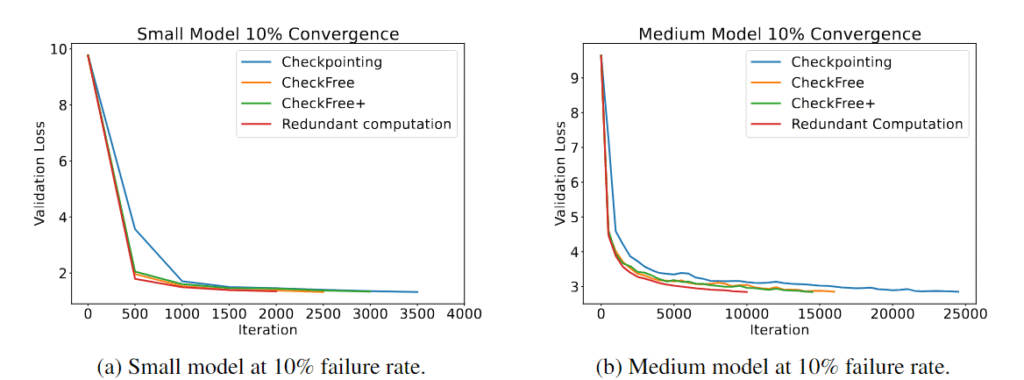

قمنا بتقييم CheckFree وCheckFree+ بشكل واسع مع معدل أعطال يتراوح بين 5% و16% في الساعة، مقارنةً بالـ checkpoints التقليدية والحسابات الزائدة. لاحظنا أنه عبر أحجام نماذج مختلفة يمكن لـ CheckFree وCheckFree+ التقارب أسرع بالزمن الفعلي للتدريب مقارنة بالأساليب الحديثة. ومع ذلك، تتباطأ سرعة التقارب بعدد التكرارات مقارنةً بخط الأساس بدون أعطال (مكافئ للحسابات الزائدة). لكن بفضل آلية الاستعادة الخفيفة، يمكن لـ CheckFree وCheckFree+ تحقيق إنتاجية أعلى بكثير، ما يجعلها مناسبة جدًا للتدريب الموزع جغرافيًا للنماذج اللغوية الكبيرة.

لماذا هذا مهم

في التدريب اللامركزي، يمكن أن تدخل العقد وتخرج من الشبكة في أي وقت، مما قد يؤدي إلى فقدان مرحلة كاملة. حتى في التدريب الموزع على نسخ متعاقبة يمكن فقدان مرحلة كاملة إذا كانت العقد جميعها في منطقة واحدة. الـ checkpoints قد تكون مكلفة جدًا بسبب عمليات الاسترجاع المتكررة، بينما الحسابات الزائدة قد تكون غير ممكنة للنماذج الكبيرة بسبب تضاعف متطلبات الذاكرة. يقدم CheckFree وسيلة فعّالة للتعافي أثناء تدريب LLM دون حسابات أو اتصالات إضافية.

تعرّف أكثر

- اقرأ المقال

- استكشف المستودع

- انضم للنقاش: Discord · X