Diverse Expert Ensembles: Farklı Uzmanlar Tabanlı Paralel LLM’ler

Bu bilimsel makale, paralel işleme ile uzmanlar topluluklarının eğitimi sırasında heterojenliğin (farklı model boyutları ve eğitim adımları sayısı) avantajlarını ele almaktadır. Farklı hesaplama kaynaklarında ve farklı zaman dilimlerinde eğitilen çeşitli modellerin birleşiminde, aynı yapılandırmalarla eğitilen homojen modellere göre daha iyi performans gösterdiğini keşfettik.

Diverse Expert Ensembles

Mixture-of-Experts (MoE) türündeki modeller, hesaplama verimliliği ve performansları sayesinde popülerlik kazanmaya devam etmektedir. Ancak, modüler yapılarının olmasına rağmen, onları hala yoğun monolitik ağlar gibi eğitiyoruz. Yani, tüm hesaplama kaynakları ve uzmanların hiperparametreleriyle yönetilen büyük veri merkezlerinde.

Gensyn olarak, uzun zamandır AGI’nin bir şirketin monolitik modeli yerine, tıpkı internetin kendisi gibi, birbiriyle ilişkili modellerin açık bir ekosisteminden oluşacağına inanıyoruz. Dahası, modellerin çeşitliliği bu ekosistemi zayıflatmak yerine güçlendirecektir.

Bugün, bu hipotezi destekleyen ilk sonuçlarımızı tanıtmaktan mutluluk duyuyoruz.

Introducing Heterogeneous Domain Expert Ensemble (HDEE)

HDEE, paralel öğrenme kullanarak eğitilen heterojen MoE modellerinden oluşan çeşitlendirilmiş uzman birleşimlerini oluşturmak için bir framework’tür.

HDEE, Li ve ark. (2022) tarafından geliştirilen paralel öğrenme Branch Train Merge (BTM) yöntemine dayanır. Bu çalışmada, “yeni bir LLM sınıfının alt modellerini farklı veri alt kümelerinde bağımsız olarak eğitmenin mümkün olduğu, LLM eğitimi için şu anda gereken kitlesel çoklu görevli senkronizasyonun dışlanabileceği” gösterilmiştir. Bizim çalışmamız, BTM’yi heterojen model boyutları ve eğitim parametreleri kullanacak şekilde genişletmenin (yani farklı hesaplama yeteneklerinin desteklenmesi) gerçekte sonraki birleşik modelin performansını artırdığını göstermektedir.

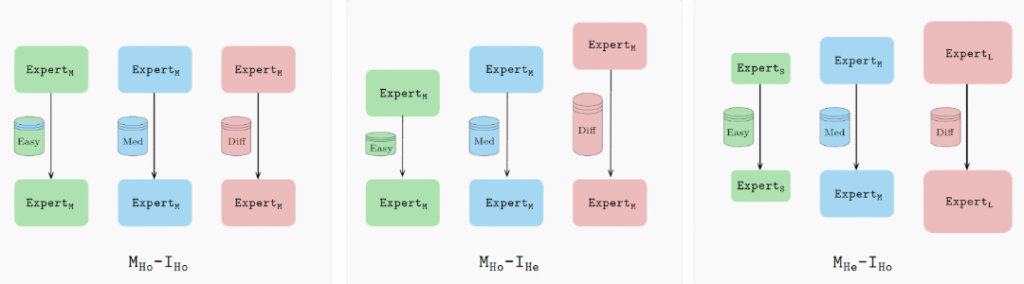

Özellikle, tüm uzmanları aynı yapılandırmalarla eğitmek yerine, HDEE her bir uzmanı veri alanı ve/veya hesaplama yeteneklerine göre seçer. Daha basit alanlar için daha küçük bir model (ya da daha az iterasyonla eğitilmiş bir model) kullanılır; daha karmaşık alanlar için daha büyük modeller ve daha uzun eğitim süreleri uygulanır.

Bu yapılandırmalar, her uzmanı optimal bir şekilde ayarlayarak daha güçlü bir birleşim sağlar. Genel olarak, heterojen birleşim, eşdeğer hesaplama bütçesi kullanarak, temel modele kıyasla değerlendirilen 21 alandan 20’inde en iyi perplexity değerine ulaşır.

Geleceğe Bakış

HDEE, açık model ekosistemine erken bir bakış sunar. Bağımsız geliştiriciler, verilerine ve uzmanlık alanlarına uygun yapılandırmaları kullanarak farklı donanımlar üzerinde modelleri eğitebilirler. HDEE ve benzeri yöntemler, bunları meta-modellere entegre edebilir, bu meta-modeller de en iyi yolu seçerek sorguları yönlendirebilir; bu, internetin kendisine çok benzer bir şekilde çalışır.

Gensyn, bunun için ana altyapıyı geliştiriyor ve geliştiricilerin modellerini eğitmelerine, doğrulamalarını ve modellerini dünyadaki tüm ML-destekli cihazlarda birleştirmelerine olanak tanıyor.

Daha fazla bilgi edinmek için tam makaleyi buradan okuyabilirsiniz.

HDEE tamamen açık kaynaklıdır ve araştırma topluluğunun bu kod üzerinden kendi geliştirmelerini yapmalarını teşvik ediyoruz.