RL Swarm: सहयोगात्मक रिइन्फोर्समेंट लर्निंग के लिए एक फ्रेमवर्क

यह ओपन सोर्स कोड (MIT लाइसेंस) पीयर-टू-पीयर नोड्स के लिए है, जो इंटरनेट पर सहयोगात्मक रीइन्फोर्समेंट लर्निंग करते हैं और इसे कोई भी उपभोक्ता या डेटासेंटर हार्डवेयर पर एक्सेस कर सकता है।

हम लंबे समय से विश्वास करते हैं कि मशीन लर्निंग का भविष्य विकेंद्रीकृत और खंडित होगा। हमारे वर्तमान मोनोलिथिक मॉडल को ऐसे खंडित पैरामीटर से बदला जाएगा जो दुनिया भर के प्रत्येक उपकरण पर मौजूद होंगे। हमारे शोध में, हम इस भविष्य की ओर विभिन्न रास्तों का अध्ययन कर रहे हैं और हाल ही में यह पाया है कि रिइन्फोर्समेंट लर्निंग (RL) विशेष रूप से प्रभावी ढंग से काम करता है जब मॉडल एक साथ प्रशिक्षित होते हैं, एक दूसरे से संवाद करते हैं और एक दूसरे के उत्तरों की आलोचना करते हैं।

हम इस निष्कर्ष पर पहुंचे हैं कि RL-मॉडल सामूहिक समुदाय के रूप में प्रशिक्षित होने पर जल्दी सीखते हैं, न कि अकेले।

तंत्रिका तंत्र के इस तंत्र का विवरण यहां पढ़ें या लाइव डेमो में शामिल होकर इस तकनीक को क्रियावली में देखें।

यह कैसे काम करता है

हमारी सेटिंग में, समुदाय में प्रत्येक नोड Qwen 2.5 1.5B मॉडल को चलाता है और गणितीय समस्याओं (GSM8K) को तीन चरणों में हल करता है:

- चरण 1 (उत्तर):

प्रत्येक मॉडल स्वतंत्र रूप से समस्या का समाधान करता है, अपने तर्क और उत्तर को निर्दिष्ट प्रारूप में प्रस्तुत करता है। - चरण 2 (आलोचना):

प्रत्येक मॉडल अन्य मॉडलों द्वारा प्रस्तुत उत्तरों पर विचार करता है और अपनी प्रतिक्रिया देता है। - चरण 3 (समाधान):

प्रत्येक मॉडल प्रत्येक प्रश्न का सबसे अच्छा उत्तर चुनने के लिए मतदान करता है। फिर प्रत्येक मॉडल अंतिम संशोधित उत्तर प्रस्तुत करता है।

हमारे प्रयोगों में हमने पाया कि यह प्रणाली सीखने की गति को तेज करती है, जिससे मॉडल बिना देखे गए परीक्षण डेटा पर कम प्रशिक्षण चरणों में अधिक सटीक उत्तर दे सकते हैं।

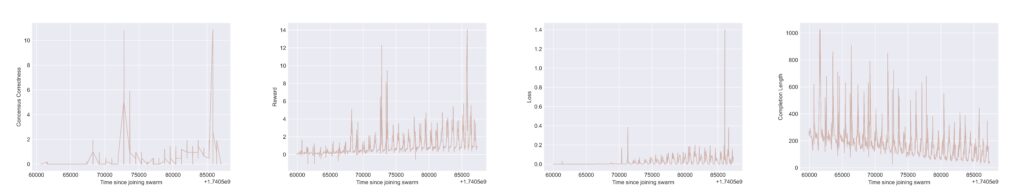

उपरोक्त प्लॉट्स स्वार्म (कंप्यूटर नेटवर्क) में एक नोड के Tensorboard परिणामों को दर्शाते हैं। प्रत्येक प्लॉट में हम बहु-चरणीय गेम के दौर के बीच “रीसेट” के कारण चक्रीय व्यवहार देखते हैं। सभी प्लॉट्स में एक्स-एक्सिस (क्षैतिज अक्ष) पर स्वार्म में शामिल हुए समय से अवधि दिखाई गई है। वाई-एक्सिस (ऊर्ध्वाधर अक्ष) पर, बाएं से दाएं ओर जाते हुए, हम देखते हैं:

i) “सहमति शुद्धता पुरस्कार” (consensus correctness reward), जो तब दिया जाता है जब स्वार्म प्रतिभागी ने सर्वोत्तम उत्तर के लिए अपने विकल्पों को सही ढंग से प्रारूपित किया हो और उसके चुने हुए उत्तर वास्तव में गणितीय रूप से सही थे;

ii) कुल पुरस्कार (total reward), जो कई नियम-आधारित पुरस्कारों का भारित योग है (जैसे कि प्रतिक्रियाओं के प्रारूपण और गणितीय/तार्किक शुद्धता की जाँच);

iii) प्रशिक्षण हानि (training loss), जो पुरस्कार अधिकतमकरण के लिए प्रतिक्रिया संकेत को दर्शाती है और इसे “आधार” एलएलएम (बेस LLM) को अद्यतन करने के लिए प्रसारित किया जाता है; तथा

iv) मॉडल की प्रतिक्रिया पूर्णता लंबाई (response completion length), जो आउटपुट प्रतिक्रिया में टोकन्स की संख्या को दर्शाती है (इससे पता चलता है कि मॉडल अपने साथियों द्वारा आलोचना किए जाने पर अधिक संक्षिप्त होना सीखते हैं)।

समुदाय में शामिल होना

इस प्रणाली का प्रदर्शन और प्रयोगों को स्केल करने के लिए, हम लाइव डेमो जारी कर रहे हैं, जिसमें कोई भी उपयोगकर्ता शामिल हो सकता है। यह एक पूरी तरह से ओपन सिस्टम है जो इंटरनेट के माध्यम से RL प्रशिक्षण समुदाय बनाने की अनुमति देता है।

स्वार्म-नोड चलाना आपको एक नया स्वार्म क्लस्टर बनाने या किसी मौजूदा नोड से सार्वजनिक पते का उपयोग करके कनेक्ट करने की अनुमति देता है। प्रत्येक क्लस्टर सामूहिक रूप से रिइन्फोर्समेंट लर्निंग (RL) प्रशिक्षण करता है, Hivemind आधारित गॉसिप एक्सचेंज प्रणाली का उपयोग करके मॉडल्स को सहयोगी रूप से सुधारने के लिए।

इंटिग्रेटेड क्लाइंट को चलाने से आपको क्लस्टर से जुड़ने, संदेश प्राप्त करने और अपनी मॉडल को स्थानीय रूप से समुदाय का हिस्सा बनाते हुए प्रशिक्षित करने की अनुमति मिलती है। भविष्य में हम स्वार्म प्रणाली के लिए और अधिक प्रयोगों की शुरुआत करेंगे और समुदाय की व्यापक भागीदारी का स्वागत करेंगे।

स्वार्म में शामिल हों

प्रौद्योगिक रिपोर्ट

***

RL Swarm मशीन लर्निंग का भविष्य देखने का एक तरीका है। यह सहभागियों के बीच सहयोगात्मक RL के लिए एक फ्रेमवर्क प्रदान करता है, जहाँ बुद्धिमत्ता सामूहिक ज्ञान का उपयोग करती है, न कि बंद प्रयोगशालाओं के सीमित दायरे से। स्केलिंग को एक खुले कंप्यूटिंग नेटवर्क की आवश्यकता होगी जो दुनिया के प्रत्येक उपकरण को जोड़ता है। विस्तार से जानकारी — जल्द ही।