SkipPipe: 분산 학습을 위한 효율적인 통신 방법

이 논문은 파이프라인 병렬 학습에서 효율적인 통신 방법에 대해 다룹니다. 여기서는 단계 건너뛰기를 최적화하여 생산성과 내결함성을 극대화하는 최적 계획 알고리즘을 제시합니다. 이 방법은 분산 학습 반복 시간을 55%까지 단축시키고, 추론 중 50% 노드 고장에 대해 7%의 페르플렉시티 손실만 발생시키는 내결함성을 보장합니다.

최근 대형 언어 모델의 발전은 규모 덕분에 이루어졌습니다. 더 큰 데이터 세트와 파라미터 수의 증가는 더 나은 모델을 만들었습니다. 이 추세는 예측 가능한 성능 향상을 가져왔지만, 비용은 한계에 다다랐으며, 이제 모델은 훈련 과정에서 수천 개의 비싼 상호 연결된 노드로 분산되어야 합니다.

이 문제를 해결하려면 학습 과정에서 노드 간 통신을 제한하는 새로운 방법이 필요합니다. 이는 지리적으로 분산된 장비에서 학습할 수 있는 기회를 열어주며, 현재의 병목 현상을 해결합니다.

이 분야의 대부분의 초기 연구는 데이터 병렬화 방법에 집중했으며, 각 노드는 독립적으로 모델 복사본을 학습하고, 몇 번의 희소한 간격으로 그라디언트 업데이트를 공유합니다. 이 방법들은 원래 통신 효율성 면에서 좋은 출발점이지만, 각 노드가 전체 모델을 메모리에 저장해야 하므로 모델 크기는 가장 작은 참여 노드의 메모리 용량에 의해 제한되어 확장성이 좋지 않습니다.

SkipPipe 소개

우리는 SkipPipe를 개발했습니다 — 분산 환경에서 학습 최적화를 위해 단계를 동적으로 건너뛰고 재분배하는 내결함성 있는 파이프라인 병렬 학습 방법입니다. SkipPipe는 이러한 환경에서 기존의 파이프라인 학습 방법에 비해 학습 시간을 55% 단축시킵니다. 또한, 50% 노드 고장에 대한 내결함성을 제공하며, 추론 중 모델 파이프라인의 절반이 고장 나도 7%만 페르플렉시티가 손실됩니다.

기존의 데이터 병렬 학습 방법과 달리, SkipPipe는 대형 모델을 학습할 수 있습니다. 모델을 단순히 데이터 세트로 나누는 것이 아니라, 모델 자체를 노드 간에 분배하여 각 노드의 메모리 사용량을 줄이고, 모델 크기 제한을 없애 이론적으로 무한 크기의 모델을 분산되고 분권화된 인프라에서 구축할 수 있게 합니다.

작동 방식

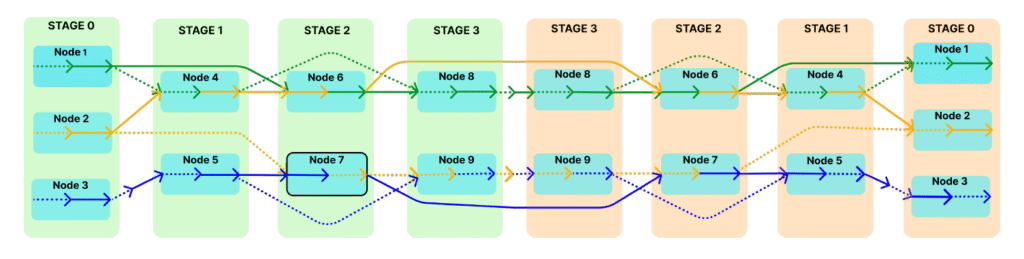

SkipPipe는 전통적인 파이프라인 병렬화에 기반을 두고, 각 미니 배치에 대해 어떤 단계를 실행할지 동적으로 선택하여 각 단계를 순차적으로 처리하는 대신, 특정 단계를 건너뛰도록 합니다. 전통적인 파이프라인에서는 각 미니 배치가 모델의 모든 계층을 통과해야 하며, 하나의 단계가 지연되면 모든 후속 단계가 대기해야 합니다. SkipPipe는 건너뛰기 비율(k%)를 설정하여 미니 배치가 지연을 유발할 수 있는 특정 계층을 건너뛰도록 허용합니다.

SkipPipe는 네트워크를 통해 사용할 수 있는 계산 경로를 분석하고 최적 경로를 선택하는 새로운 스케줄링 알고리즘을 사용합니다. 이는 GPU의 유휴 시간을 최소화하고, 고장난 노드나 느린 노드를 우회하여 내결함성을 높입니다.

결론

SkipPipe는 분산(및 분권화된) 학습을 위한 핵심 빌딩 블록을 제공합니다. 기존의 데이터 병렬화에만 집중한 연구와 달리, 파이프라인 병렬화에 집중하여 모델 크기 제한을 제거하고, 여러 분산 노드를 통해 모델을 확장할 수 있습니다. 이는 단순히 모델을 복제하고 병렬로 학습하는 기존 방법과 다릅니다.

협력 시스템 및 신뢰할 수 있는 검증 방법과 결합하면 SkipPipe는 크라우드소싱 계산을 통해 대형 첨단 모델을 효율적으로 학습시킬 수 있게 합니다.

자세히 알아보려면, 전체 논문을 여기서 읽을 수 있습니다.

SkipPipe는 완전히 개방되어 있으며, 연구 커뮤니티가 이 코드를 기반으로 개발을 구축할 수 있도록 권장합니다.