RL Swarm:协同强化学习的框架系统

这是一个开源代码(MIT 许可证),用于点对点节点在互联网上执行协作式强化学习,任何人都可以通过消费级硬件或数据中心硬件访问

我们一直相信,机器学习的未来将是去中心化和碎片化的。我们当前的单体模型将被分散在全球每个设备上的碎片化参数所取代。在我们的研究中,我们探索了通向这一未来的不同路径,并且最近发现,强化学习(RL)在模型互相交流并批评彼此答案时,特别有效。

我们得出结论,RL 模型在作为一个集体社区共同学习时,比单独学习的速度更快。

有关机制的详细信息请参阅这里,或者加入实时演示,亲眼看到技术的实际应用。

工作原理

在我们的设置中,社区中的每个节点运行 Qwen 2.5 1.5B 模型,并分三个阶段解决数学问题 (GSM8K):

- 阶段 1(回答):

每个模型独立解决问题,并以指定格式输出推理过程和答案。 - 阶段 2(批评):

每个模型审查其他模型提供的答案,并给出反馈。 - 阶段 3(解决):

每个模型投票选出最佳答案。然后,每个模型提供最终修正的答案。

在我们的实验中,我们发现该系统加速了学习,使模型能够在较少的训练步骤下,对未见过的测试数据给出更准确的答案。

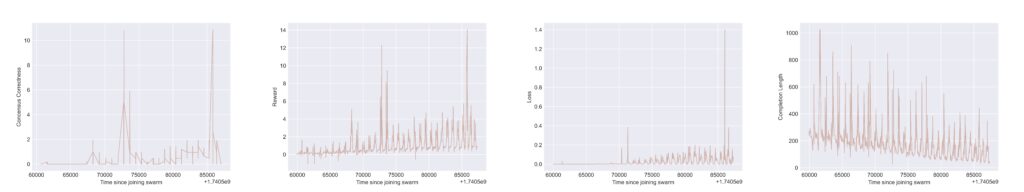

上述图表展示了集群中某个节点的 Tensorboard 结果。每个图表中出现的周期性波动是多阶段游戏轮次间”重置”操作造成的现象。所有图表均以加入集群后的时间为横轴(x轴)。从最左侧图表开始向右,纵轴(y轴)依次表示:

i) “共识正确性奖励”:用于衡量该集群参与者是否正确格式化其最佳答案选项,且所选答案在数学层面确实正确;

ii) 总奖励:多个基于规则的奖励加权总和(包括格式检查及响应内容的数学/逻辑正确性验证);

iii) 训练损失:反映为最大化奖励而传播至基础大语言模型(LLM)的反馈信号;

iv) 模型响应完成长度:统计输出响应中的令牌数量(表明模型在同伴评审反馈后学会生成更简洁的响应)。

加入社区

为了演示该系统并扩展实验,我们发布了实时演示,任何用户都可以加入。这是一个完全开放的系统,用于通过互联网创建 RL 学习社区。

启动 swarm-node 使您能够创建一个新的蜂群集群或使用其公共地址连接到现有节点。每个集群集体进行强化学习(RL),并采用基于 Hivemind 的八卦交换系统共同改善模型。

启动内置客户端允许您连接到集群、接收消息并作为集体的一部分本地训练您的模型。未来,我们将为蜂群系统启动更多实验,并欢迎社区广泛参与。

***

RL Swarm 是机器学习未来的一个展望。它提供了一个框架系统,用于参与者之间的协同 RL,其中智能利用集体智慧,而不是受限于封闭实验室的狭隘圈子。扩展将需要一个开放的计算网络,连接全球每一个设备。更多细节—敬请期待。