Verde:在不可靠节点上进行机器学习验证的协议

这是一篇学术论文,描述了Verde(一种用于机器学习程序的验证协议)及其底层支撑技术——可复现算子(RepOps)系统。RepOps是一个能够确保机器学习工作在不同硬件间实现比特级结果复现的代码库。

Gensyn 网络创建了一个全球开放的机器学习计算市场。它允许任何用户提供资源——从数据中心到 MacBook——并在所有设备上确保一致的执行。这使得开发者能够以低成本训练超大规模的模型,并开辟了以前无法实现的协同学习新形式。

为了实现这一概念,我们需要一个可扩展的机制来验证不可靠提供者的工作。天真地做法是使用受信任的中介来复现每个任务,或手动将提供者列入信任名单。在这两种情况下,我们很快会遇到可扩展性的限制:在第一个情况下,复制的开销将是不可接受的;在第二个情况下,我们将排除掉那些希望参与的长尾提供者。

更复杂的方法,如加密证明系统,保证正确性,但对于大规模的机器学习任务(至少目前来说)来说,它们成本过高。启发式方法,如学习证明或训练数据证明,通过提供弱安全保证来提高效率。

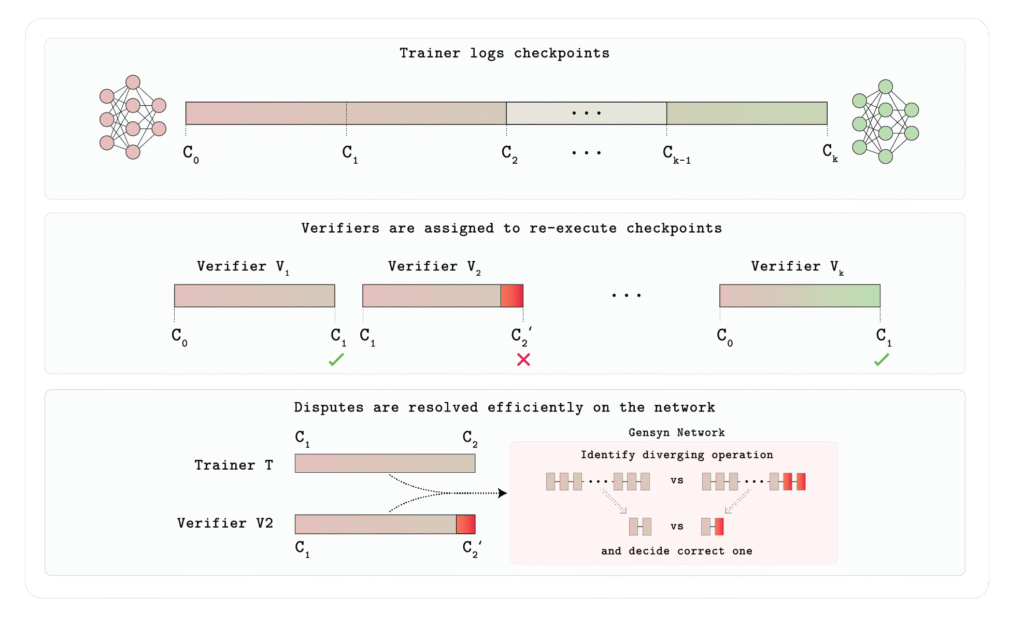

因此,我们转向仲裁委托的概念,利用验证者来验证每个提供者的工作。如果验证者认为提供者的输出是错误的,可以通过有效的争议解决博弈说服中立的仲裁者。这些技术构成了区块链汇聚中使用的乐观验证的基础,如 Arbitrum 和 Optimism,其中区块链验证者充当仲裁者。整个交易块的争议可以得到…

然而,仲裁委托与现代机器学习有两个不兼容的地方。首先,它是为 CPU 程序设计的,对于大规模神经网络转化来说效率较低。其次,它假设诚实的服务器总是会对同一程序计算出相同的结果,而在机器学习中,如果使用不同的硬件,往往不成立。

任何可行的机制必须解决这些问题,并且具有可扩展性。

介绍 Verde

今天,我们很高兴介绍 Verde——第一个专门为现代机器学习在去中心化环境中设计的验证协议。

Verde 由一个轻量级的争议解决系统组成,该系统确定了训练的第一步和神经网络计算图中与训练者和验证者不同的操作符。现在,验证者(可以是智能合约或验证者陪审团)只需重新计算这个争议操作符,而不是重复执行整个任务。这大大减少了验证的开销,同时保证了只要至少有一个验证者是诚实的,正确的结果就能得到保证。

可重现性

为了使该系统工作,我们需要确保机器学习程序在所有硬件设置上都是可重现的,这样不同的(诚实的)节点将计算出相同的结果,无论它们使用什么设备。通常情况下,默认情况下并非如此,即使是同一厂商的不同设备(例如,Nvidia A100 与 H100)也可能存在差异。

为了解决这个问题,我们创建了可重现操作符(RepOps),这是一个实现流行 ML 操作符逐位可重现版本的库。它解决了硬件不确定性的问题,通过确保浮点运算执行的顺序在计算矩阵乘法等函数时是固定的。这保证了诚实的提供者始终会输出逐位相同的结果,从而确保 Verde 争议解决协议的可靠性。

结论

Verde 为去中心化机器学习提供了一个基本的构建块系统。它使 Gensyn 能够将全球范围内的每个计算设备——从数据中心到边缘设备——无许可且可扩展地连接到系统中。

要了解更多信息,您可以阅读完整的文档这里。

要查看使用 RepOps 的可重现性如何在实时演示中工作,请遵循此处的说明。